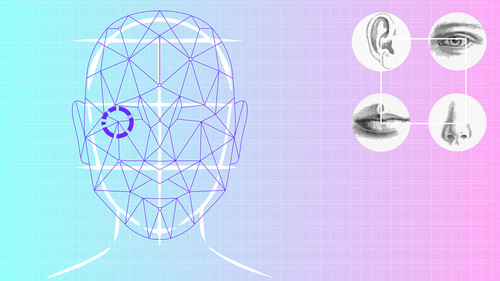

I sistemi di riconoscimento facciale decidono il tuo sesso al posto tuo

Se sei stato nella metropolitana brasiliana di San Paolo nel 2018, potresti aver incrociato un nuovo tipo di pubblicità. Pannelli interattivi luminosi che presentavano contenuti mirati, secondo le ipotesi fatte da un algoritmo, in base all’aspetto di chi osserva. Dotati di telecamere di riconoscimento facciale, gli schermi hanno stimato sesso, età e stato emotivo dei passeggeri, e hanno proposto annunci pubblicitari basati su queste informazioni.

I gruppi per i diritti digitali sostengono che l’algoritmo viola i diritti delle persone transgender e non binarie perché stima il genere degli individui in base alla forma fisica del loro viso, potenzialmente facendo giudizi errati sulla loro identità. L’algoritmo è basato su un modello di genere strettamente maschile/femminile, ignorando l’esistenza di persone non binarie.

«Se questi sistemi non riescono a comprendere che esisti, allora vivi sostanzialmente in uno spazio che ti sta costantemente e sinuosamente informandoti che non sei reale», ha detto Os Keyes, ricercatore di intelligenza artificiale presso l’Università di Washington.

Keyes, britannico, fa parte di una campagna per il rispetto della privacy LGBTQ+ ed esortare la Commissione europea a vietare la tecnologia automatizzata di riconoscimento di genere. L’Unione europea prevede di rivelare una nuova proposta di regolamentazione dell’intelligenza artificiale questo mese. Gli attivisti sperano che bandirà la tecnologia che fa ipotesi sul genere e l’orientamento sessuale.

«Vogliamo costruire un percorso nell’intelligenza artificiale che non sia soltanto il liberismo cinese o statunitense, ma basato sui diritti umani», ha dichiarato Daniel Leufer, analista di Europe Policy presso il gruppo per i diritti digitali Access Now.

La tecnologia automatizzata di riconoscimento del genere è già una realtà quotidiana. Un esempio è Giggle, un social media per sole donne comparso per la prima volta nel 2020. Giggle utilizza l’intelligenza artificiale per il riconoscimento facciale per “verificare” il genere degli utenti, analizzando un selfie inviato da chi intende iscriversi.

«È scienza!» ha dichiarato allegramente il sito web rosa dell’app, prima di ammettere che «a causa dell’algoritmo di verifica del genere utilizzato da Giggle, le ragazze transessuali avranno problemi a essere verificate». Gli utenti e i media hanno criticato l’app come trans-escludente e basata su idee obsolete su come dovrebbero essere le donne. Da allora il sito Web del social è cambiato ma non menziona come le donne transessuali possono aderire.

L’AD di Giggle, Sall Grover, mi ha detto che l’app è stata moderata da esseri umani che «guardano sempre dietro gli schermi per garantire che Giggle rimanga uno spazio femminile,» aggiungendo che «esistono app specifiche per i gay o specificamente per le persone transgender e noi le sosteniamo».

Grover ha detto che «le femmine trans-identificate sono le benvenute sulla piattaforma Giggle, se lo desiderano», ma quando le viene chiesto di specificare come le donne trans dovrebbero navigare nel software di riconoscimento di genere, ha semplicemente risposto: «Giggle è un social per donne». Poco prima della pubblicazione di questo pezzo Grover ha detto, in un tweet, che l’app era «rigorosamente per le femmine biologiche».

Il riconoscimento automatizzato di genere è un altro strumento, dicono gli attivisti, per rafforzare le nozioni errate di genere, come gli stereotipi e i pregiudizi che li accompagnano. La tecnologia stessa «funziona molto male per le persone transessuali e non funziona affatto per le persone non binarie», ha dichiarato Yuri Guaiana di All Out, un gruppo internazionale di difesa LGBTQ+ che sta attuando una campagna per la messa al bando di queste tecnologie.

Le entrate pubblicitarie sono spesso un incentivo per le aziende a voler assegnare un genere agli utenti. Questo mese, Access Now ha inviato una lettera alla piattaforma di streaming musicale Spotify, criticandola per la tecnologia sviluppata per rilevare il genere di un utente analizzando il modo in cui parla, al fine di formulare raccomandazioni musicali.

«Questa tecnologia avanzata, che ci viene detto rivoluzionerà la società, sta in realtà cementando gerarchie sociali conservatrici e obsolete», ha affermato Leufer.

Spotify non ha risposto alla richiesta di un commento.

Gli attivisti pensano che, se questa tecnologia non verrà messa fuori legge, diventerà presto onnipresente. C’è anche la preoccupazione che nei paesi autoritari, dove l’essere persona LGBTQ+ viene considerato un crimine, potrebbe essere implementato per far “fuori” individui vulnerabili.

«Francamente, tutte le persone transessuali che conosco, me compreso, hanno abbastanza problemi con persone misogene, senza che i robot inizino a divertirsi», ha detto Keyes.

Articoli correlati

Le trappole dell'Intelligenza Artificiale

Le trappole dell'Intelligenza ArtificialeSarebbe una fake new la lettera del Presidente del Burkina Faso Traoré a Papa Leone XIV

Circola un video in cui il presidente Traoré pronuncia un duro discorso anticolonialista. Utilizzando una funzione di "deep research" dell'Intelligenza Artificiale siamo riusciti a verificarne la veridicità e a scoprire che sarebbe una fake new forse generata con l'Intelligenza Artificiale stessa.18 maggio 2025 - Redazione PeaceLink Nota sul rapporto tra intelligenza artificiale e intelligenza umana

Nota sul rapporto tra intelligenza artificiale e intelligenza umanaAntiqua et nova

In questo rapporto, redatto dai Dicasteri per la Dottrina della Fede e per la Cultura e l’Educazione, emerge l’urgenza di trattare l’IA non come un’entità autonoma, ma come un prodotto umano, da governare attraverso scelte collettive che rispettino l’etica, l’equità e la giustizia.28 gennaio 2025 - Redazione PeaceLink A coloro che interpretano il mondo invece di cambiarlo

A coloro che interpretano il mondo invece di cambiarloUn approccio quasi marxista all'Intelligenza Artificiale

Questi appunti, scritti in forma provocatoria, sono rivolti a tutti quelli che stanno alla finestra e fanno da spettatori nei confronti della più grande rivoluzione del nostro tempo. L'Intelligenza Artificiale la usano i cattivi mentre i buoni brontolano.28 dicembre 2024 - Alessandro Marescotti Che cosa del ragionamento umano non può essere implementato

Che cosa del ragionamento umano non può essere implementatoL’intelligenza artificiale come grande sfida

Una panoramica storica e filosofica per analizzare i limiti dell’Intelligenza Artificiale nel replicare pienamente la complessa capacità umana di generare approcci logici alternativi. Il saggio affronta anche le implicazioni etiche e politiche connesse all'ambito militare.23 dicembre 2024 - Antonino Drago